Los argumentos de Terminator y más recientemente la vaga adaptación cinematográfica de I, robot, las cuales dieron rienda suelta a la imaginación de novelistas, ingenieros, programadores e incluso y un tanto al fondo, de abogados, pero siempre viendo estos eventos en un horizonte lejano, eventos que quizás esa y las generaciones venideras no verían, eventos que no nos tocaría regular o experimentar. Pero el futuro nos alcanzó.

El argumento de las primeras dos películas a cargo de James

Cameron, así como la novela de Isaac Asimov en la que se dice se basa la

película de mismo nombre, han sido suficientes para establecer una base de fans

que a lo largo de múltiples películas, series, videojuegos, comics, etc., se

han planteado cuestionamientos por resolver, muchos explorando en distintos

campos como la filosofía, el derecho e incluso la mecánica cuántica, logrando

aproximaciones sobre cómo resolver dichas cuestiones, sin embargo, hoy día se

hacen más presentes que nunca por un entorno que nos muestra que lo que vimos

como ciencia ficción, hoy ya no es ficción y se vuelve un tema que a esta

generación le corresponde enfrentar tanto en el campo de la ciencia, como en el

de la regulación local e internacional: ¿Qué regulación podría tener la

inteligencia artificial? ¿Qué responsabilidad se le puede atribuir a las máquinas

autónomas? ¿Cuándo se considera una maquina completamente autónoma? ¿Pueden las

máquinas atacar deliberada y autónomamente a los humanos?

LAWS: un acrónimo contradictorio que no está regulado específicamente.

Conforme fue avanzando la tecnología de la mano de las

innovaciones que año con año presentaba la humanidad, toda clase de

dispositivos se fueron haciendo menos dependientes de la manipulación humana;

al mismo tiempo, la concepción de dispositivos dotados de inteligencia

artificial se fue fortaleciendo al punto de plantear la total autonomía de

redes y aparatos que convivieran con la humanidad, por lo que el temor de

muchos y sueño de otros, paulatinamente se comenzó a cristalizar.

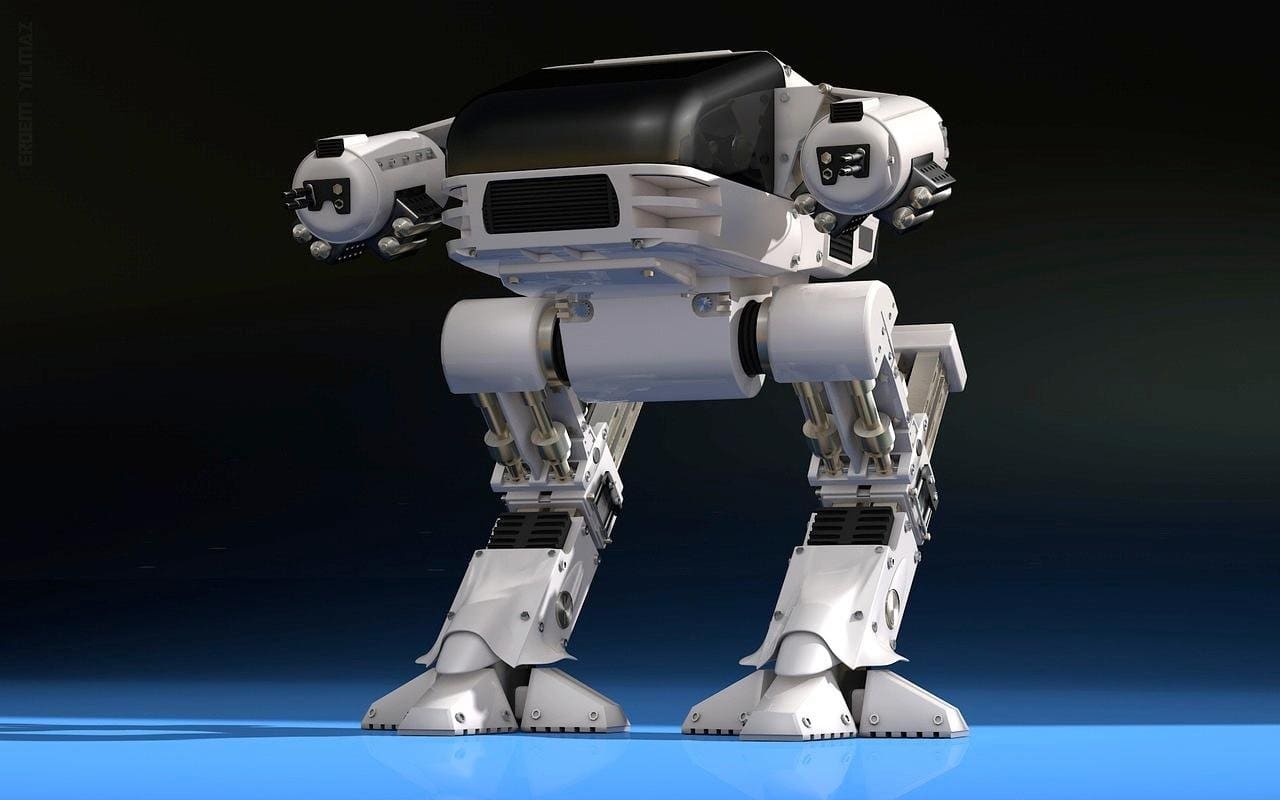

En este punto vale la pena señalar que históricamente, conforme se han dado innovaciones tecnológicas y científicas, éstas se han aplicado con fines militares para conceder una ventaja estratégica al territorio de su descubridor o desarrollador y los ejemplos abundan en la historia y el presente no es la excepción. Si bien el desarrollo de inteligencia artificial ha tenido grandes logros y avances en la medición de hábitos de consumo para ayudar en la salud a sectores de la población en riesgo, en la predicción de rutinas de escritura y conversación, en la conducción de vehículos autónomos, obtención y aplicación de datos de consumo de clientes potenciales clientes para ciertas empresas, así como aplicaciones en sectores industriales como el automotriz o la prevención de riesgos, también se ha buscado aplicar a la industria militar, tanto en el desarrollo de armas como en el accionar de las mismas, pero hasta ahora y de forma oficial, con fines de defensa.

Doctrinariamente se denomina Lethal Autonomous Weapons System (LAWS) o sistemas de armas autónomas letales (SAA) a aquellas que son capaces de llevar a cabo sus objetivos sin la intervención humana, las cuales pueden estar implicadas en las actividades de reconocimiento y vigilancia, hasta las que son empleadas para la defensa y que potencialmente puedan convertirse en letales por su operación autónoma. Debe diferenciarse que, si bien el término en inglés incluye la palabra lethal, es decir, letal o mortal, no todos los Sistemas de Armas Autónomas tienen el fin de provocar bajas humanas de forma activa, sino que de existir “casualties” o daños colaterales, se dan como consecuencia de la operación en defensa de sus objetivos.

Del consenso de expertos y desarrolladores de SAA se puede

abstraer a priori que estas armas pueden ser o no letales y que

el grado de autonomía se ve determinado por el grado de implicación humana en

su funcionamiento. De este modo es que se vislumbra que no todo SAA es

necesariamente autónomo, como los drones o vehículos de combate no tripulados

que son operados remotamente o que requieren de la confirmación humana para

abrir fuego contra los objetivos.

Los prototipos de SAA que se han conceptualizado tienen características de inteligencia artificial ya integradas que al día de hoy resultan familiares para la población civil, ya que se ha mencionado que estos dispositivos tendrían mecanismos para reconocimiento e individualización de objetivos por vía de medios biométricos o reconocimiento facial, mecanismos que ya son usados en diversas aplicaciones de entretenimiento, banca y finanzas o de seguridad personal.

De hecho, los SAA ya tienen cierta fama a nivel internacional y recientemente a la fecha que se escribe esta breve investigación, hemos sido testigos de la efectiva operación de una SAA que es exhibida orgullosamente por su gobierno: la Cúpula de Hierro de Israel. Con el objetivo de repeler los ataques palestinos a territorio israelí, el gobierno financió el desarrollo de un dispositivo que intercepta en el aire los proyectiles con destino a Israel, alcanzando un 90% de efectividad. Este sistema solo fue diseñado para actuar en defensa de la soberanía del territorio aéreo del país, por lo que la Cúpula de Hierro no está dotada de la capacidad de contraatacar los asentamientos palestinos.De momento no se tiene planeado emplear las SAA con fines

activos de ataque, ya que, como se verá más adelante, existen ciertas

restricciones aplicables según convenciones y tratados aplicables que conforman

el derecho de guerra de las naciones.

Ventajas y desventajas de LAWS

A criterio de expertos militares, los SAA representan una serie de ventajas al momento de ser empleadas durante hipotéticos enfrentamientos armados, ya que por un lado disminuiría las bajas de soldados efectivos desplegados en el campo de batalla, así como disminuiría la baja de civiles no relacionados con el conflicto; asimismo, focalizarían el ataque dirigido a eliminar objetivos precisos y estratégicos, aumentando la efectividad de las operaciones tácticas y disminuyendo -nuevamente- el número de bajas, tanto de civiles como de adversarios; serían capaces de reaccionar en menor tiempo que los humanos y no estarían sometidos a los reflejos o reacciones humanas; no actuarían por conducto del odio, la venganza o por motivos raciales, religiosos o sexuales y disminuirían las subjetividades por las que los soldados emplean fuerza letal innecesaria; finalmente, como todas las IA, de aumentar su uso, se puede enseñar y condicionar las Armas Autónomas a disminuir la fuerza letal eventualmente o solo aplicarla cuando sea estrictamente necesario.Por el otro lado, existen detractores que opinan lo

contrario al señalar que el empleo de este tipo de armas solo generaría

desconcierto al no existir aun una regulación propiamente aplicable a este tipo

armas, además de que las bajas, tanto militares como civiles se multiplicarían

al no existir controles efectivos que disminuyan la capacidad letal de estos

sistemas.

La regulación aplicable

Resulta contradictorio que, siendo un tema de la actualidad

y cuyas repercusiones e impacto en la sociedad y el curso de la historia puede

ser definitivo, no exista una regulación sobre los SAA y que en estos momentos

la mayor preocupación es la inteligencia artificial por todos los campos en los

que se involucra.

El borrador del Reglamento Europeo sobre Inteligencias

Artificiales incluye un preámbulo donde

se establecen las razones para adoptar regulaciones y sobre todo las amenazas

que se pretenden atajar antes de que se materialicen, así como se da a la tarea

de establecer definiciones y delimitando el campo de acción de los

desarrolladores al estimar que existen cuatro categorías de riesgo relacionadas

con las IA:

Riesgo inadmisible.

Conjunto de usos limitados que no serán tolerados en la Unión Europea, que

vienen a formar las prohibiciones.

Riesgo alto. Se

consideran así a los usos que se le dé a las IA que potencialmente pueden

impactar negativamente en la seguridad de las personas, así como en sus

derechos fundamentales, los cuales estarán sujetos al cumplimiento de

regulación como tener registros de la documentación técnica, la transparencia y

la divulgación de información a los usuarios, la supervisión humana, y la

solidez, la precisión y la ciberseguridad

Riesgo limitado. Cuando por motivos de transparencia, se tenga

que definir cuando una persona sostiene una conversación con un robot dotado de

inteligencia o patrones lógicos.

Riesgo mínimo. El uso de IA en esta categoria no implica riesgo alguno y mucho menos responsabilidad para los proveedores o usuarios.

Pese a que el artículo seis del reglamento establece que

nuevas IA que se desarrollen puedan ser consideradas de riesgo alto por el

posible riesgo o daño que representen o puedan infringir conforme a un criterio

ya establecido y armonizado, lo cierto es que desde el artículo dos del propio

reglamento se señala que éste no será aplicable a los SAA o que tengan

aplicaciones exclusivamente militares:

Artículo 2. Ámbito de aplicación

1. […]

4. El presente

Reglamento no se aplica a los

sistemas de IA utilizados exclusivamente

para el funcionamiento de armas u otros fines militares.

Artículo 6.

Actualización de los sistemas de IA de alto riesgo

1. La Comisión

está facultada para adoptar actos delegados de conformidad con el artículo

64 para actualizar la lista del

anexo II añadiendo nuevos sistemas de IA

de alto riesgo, cuando haya

identificado que otros sistemas de IA

generan un alto nivel de riesgo de daño de la misma manera que los sistemas

de IA de alto riesgo ya enumerados en el anexo II.

2. […]

3. El daño

será cualquiera de los siguientes:

(a) lesiones

o muerte de una persona, daños materiales;

Estas disposiciones podrían parecer contradictorias, pero no

se debe olvidar que en el ámbito legislativo, existen comisiones con objetivos

específicos y la encargada de asuntos de seguridad o temas militares pueden

trabajar de forma cercana con la comisión encargada de regular las IA por los

intreses que este tema les puede traer, pero ello no es óbice para discutir su

regulación y aplicaciones con el enfoque específico de su materia.

Entonces las SAA no tienen regulación actualmente.

Por lo ya revisado se podría decir a priori que los Sistemas de Armas Autónomas no cuentan con una regulación específica, sin embargo, en el ámbito legal siempre hay alternativas y modos de cumplir con regulaciones. La cláusula Martens establece que:

“Hasta que un Código más completo de las Leyes de guerra se emita, las Altas Partes Contratantes juzgan oportuno declarar que, en los casos no incluidos en las disposiciones reglamentarias adoptadas por ellas, las poblaciones y los beligerantes quedan bajo la protección y el imperio de los principios del derecho internacional, tal como resultan de los usos establecidos entre naciones civilizadas, de las leyes de la humanidad y las exigencias de la conciencia pública”, (Conferencia de Paz de la Haya de 1899),

Por lo que al hacer una interpretación tanto de este principio como de las circunstancias y que las SAA están contempladas para fines militares, su regulación se encuentra en el Derecho Internacional Humanitario y las regulaciones aplicables del ius ad bellum y del ius in bello pertinentes. Aunque la clausula Martens puede ser interpretada estrictamente como mientras que no exista un código de guerra con leyes más adelantadas o pertinentes, todo lo que no está estrictamente prohibido, está permitido”, se puede también obtener una interpretación que estima que las acciones ralizadas en guerra serán reguladas no solo por los tratados del derecho de guerra, sino por las costumbres y principios de derecho internacional.

El derecho de guerra se divide en dos primordialmente: el derecho a la guerra (ius ad bellum) y las acciones y conductas dentro de la guerra (ius in bello). Existe una gran diversidad de tratados y convenios que regulan las actividades bélicas, desde las que se apoyan en principios contenidos en libros religiosos y enseñanzas histórico-filosóficas, como los cuerpos normativos modernos, de entre los que destacan las Conferencias de Paz de la Haya de 1899 y 1907, así como las cuatro Convenciones de Ginebra de 1949, obviamente posteriores a la Segunda Guerra Mundial, así como los Protocolos adicionales a las Convenciones de Ginebra de 1977, en las que además de regular ciertas condiciones de guerra, se busca conceder niveles de protección mínima a civiles, personal diplomático, sanitario, víctimas y en general personas ajenas al conflicto pero que están inmersas en el campo de batalla, así como a heridos, náufragos y prisioneros de guerra, siendo un conjunto de normas que actualizan los protocolos de guerra, apoyándose en las directrices dictadas por el Consejo de Seguridad de las Naciones Unidas y los Principios de Núremberg.

Al respecto vale la pena mencionar que el Protocolo Adicional I

de los Convenios de Ginebra, en su artículo 36, se establece que:

Artículo 36 - Armas nuevas

Cuando una Alta Parte contratante estudie, desarrolle, adquiera o adopte una nueva arma, o nuevos medios o métodos de guerra, tendrá la obligación de determinar si su empleo, en ciertas condiciones o en todas las circunstancias, estaría prohibido por el presente Protocolo o por cualquier otra norma de derecho internacional aplicable a esa Alta Parte contratante.

Con esto, los SAA están incluidos de cierta manera en las regulaciones aplicables y vigentes en el derecho de guerra. Sin embargo, más allá de la legislación existente y por venir, las cuestiones que se presentan entran en el campo de la ontología, es decir, un sistema dotado de inteligencia artificial con capacidad de fuerza letal, ¿llegará a ser lo suficientemente inteligente como para distinguir en qué momento un militar se ha rendido o cuando un civil resiste solo por su supervivencia y no se identifica como un combatiente? Del mismo modo, ¿puede identificar cuando un vehículo tiene propósitos militares y cuándo un vehículo ha sido modificado para darle un propósito bélico sin que lo aparente? Por otro lado, también están las cuestiones éticas y morales porque ¿en qué momento dotamos a una máquina de la capacidad de terminar con la vida de un humano? Y lo que es peor, cuando dicha máquina tome la determinación por sí misma regida por sus algoritmos y programación, ¿su proceder estará justificado?

De acuerdo con los principios y el artículo relacionado con las

“armas nuevas”, ¿una inteligencia

artificial será capaz de medir en tiempo real y contener cierta fuerza

destructiva para ceñirse a la proporcionalidad que exige el Protocolo? Dicha proporcionalidad,

también implica evitar las bajas civiles producto de daños colaterales, pero si

este hecho resulta imposible, ¿quién será responsable del proceder de las armas

autónomas?

Conclusión a modo de reflexión.

La tecnología y las innovaciones científicas, a lo largo de la historia y en su mayoría, han sido empleadas con fines militares. De hecho, hay quienes afirman que tras un gran conflicto bélico, grandes avances tecnológicos suceden y hoy, en plena era digital y de las telecomunicaciones, es altamente probable que estemos viendo el nacimiento de lo último en armas. Atrás quedarán las armas de balas o explosivos, puesto que varias de éstas últimas están siendo prohibidas (de acuerdo la Convención de ciertas Armas Convencionales y sus Protocolos Adicionales), siendo relegadas quizá al mismo estatus que hoy ostentan las lanzas, espadas y hachas. Además de la preocupación que hoy producen las armas nucleares, biológicas y químicas (reguladas en La Convención de 1975 sobre Armas Bacteriológicas y La Convención de 1993 sobre Armas Químicas, además de la Opinión Consultiva de la Corte Internacional de Justicia Sobre la Legalidad de la Amenaza o Empleo de las Armas Nucleares de 1996), hoy se debe sumar a las Inteligencias Artificiales, cada día más capaces y potentes en sus procesos internos de lógica y solución de problemas, así como a su derivación letal, los Sistemas de Armas Autónomas.

Uno de los principales dilemas que presenta la introducción de armas autónomas, drones e IA es la de adaptarse o sucumbir, pero si la tecnología avanza a pasos agigantados y el principal temor es que los humanos sean sacados deliberadamente por las inteligencias artificiales en la toma de decisiones y ejecución de comandos militares, dónde queda el factor humano del aprendizaje y sobre todo, de superioridad del humano sobre la máquina. La duda que estas tecnologías plantean es si, una vez que entran en funciones, será el humano capaz de mantener el control de estas armas y siempre prevalecer sobre una Inteligencia Artificial.

Por otro lado, urge una legislación enfocada en las aplicaciones militares de las IA y los SAA, ya que si bien existen normas que hasta cierto punto las contemplan, dicha normativa es genérica y emana de un protocolo adicional datado en 1977, por lo que es altamente probable que muchas de la cuestiones éticas, legales, morales y objetivas puedan ser abordadas por un comité mixto de expertos que incluyan criterios de derecho, ingeniería, lógica, robótica, filosofía y computo cuántico.

Finalmente, existen expertos que los SAA ya sido usados en el campo de batalla, pero no solo con fines de defensa como la Cúpula de Hierro, sino que han actuado con lo que se podría llamar “iniciativa propia” y han causado bajas. Si bien estas afirmaciones pueden caer en el campo de la especulación puesto que no existen pruebas suficientes que demuestren esto, los expertos en la materia afirman que hay evidencias de armas con comportamiento autónomo que han actuado conforme a objetivos programados, valiéndose de reconocimiento facial u otros parámetros biométricos para ejecutar sus objetivos, causando daños colaterales en la población civil, como en Libia, Irán o Siria, lo que ha motivado a la creación de Organizaciones No Gubernamentales que reclaman la limitación o prohibición de estas armas como la iniciativa Stop Killer Robots, Article 36, International Committee for Robot Arms Control.Por cierto, las tres leyes de la robótica propuestas en la película I, Robot, aunque en principio serían un buen intento por legislar desde dentro a las IA, ésta regulación resultaría insuficiente en caso de que la IA cobre conciencia o evolucione a un ente con libre albedrío, hecho que se antoja casi imposible, pero en el "casi" existe una posibilidad que debería ser considerada inadmisible.

Fuentes de derecho:

Convención de Ciertas Armas Convencionales

Liga a los 4 Convenios de Ginebra de 1949 y sus protocolos adicionales

Explicación detallada del borrador Reglamento Europeo sobre Inteligencia Artificial

Principios de Derecho Internacional contenidos en la Carta del Tribunal de Nuremberg

No hay comentarios:

Publicar un comentario